高速公路管理中心与高速沿线收费站所、各部门业务联系非常紧密,对于信息共享的需求非常迫切,但目前收费站所、各业务部门间的信息孤岛问题比较严重,中心、站所、部门单位间协作水平比较低。为了解决中心、站所、部门间存在的此类问题,必须建设高速公路数据资源中心,实现信息交换、资源共享、业务联动。根据信息资源库建设实际情况,结合具体业务需求,进行有效的信息检索、整合、分析和挖掘。对于典型数据主题,开展深入主题分析应用试点,采集主题相关的各种基础数据,对数据进行建模,整合数据,填充数据模型,并利用工具进行深入的数据挖掘分析,以图表、报告等多种形式展现分析结果。

一 建设目标

高速公路系统结合现有网格化服务管理平台建设本地数据资源中心,并在此基础上建设本地信息共享和交换中心,打通本地各站所共享交换通道,建设高速公路业务协同体系。业务协同可在本地完成,数据同时上传到高速公路管理中心大数据中心存储。

搭建大数据支撑平台,利用大数据、云计算等技术,实现海量高速公路结构化数据和非结构化数据的存储。

建设本地高速公路信息综合资源库,依据高速公路的数据标准规范体系,汇集高速公路内外部共享数据的基础信息、服务应用信息,建立满足高速公路需要的高速公路信息库、综治信息库等,为高速公路各类大数据应用提供数据支撑。

建立一体化的数据管理平台,通过部署交换平台软件、数据资源管理系统、资源目录管理系统、数据质量管理系统、数据标准管理系统等软件,实现数据的标准采集、处理、管理、服务、共享等全自动化管理流程。

搭建分布式的信息共享服务平台,依托高速公路专网,以高速公路大数据中心为中心节点,以高速公路数据云为分支节点,实现各站所部门内、外横向数据交换和共享;同时,依托信息共享服务平台,实现中心及站所两级的纵向数据交换和共享。

建立高速公路大数据应用平台,运用数据建模、数据分析、数据挖掘等工具软件,加强高速公路的业务应用,依托大数据模型分析,为立体化高速公路信息平台等提供数据支撑。

二 功能设计

(一)系统架构

高速公路数据资源中心的建设紧紧围绕资源整合、统一服务、关联共享、协同应用,通过标准化的数据流程管理,实现高速公路资源按需集中、分布应用的信息化新格局。

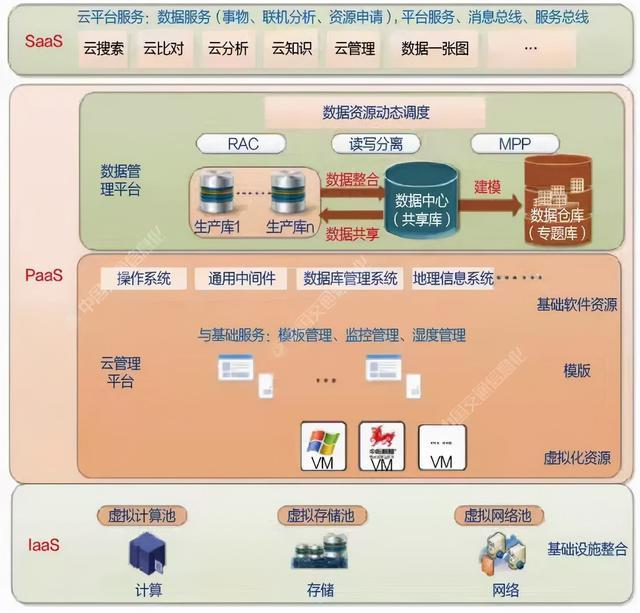

高速公路数据资源中心采用云平台架构,总体分为IT基础设施服务层、支撑平台服务层、软件服务层。

在总体架构中,IT基础设施服务层通过将计算、存储、网络等基础设施虚拟化,构建统一的资源池,在此基础上按需调度相关基础设施资源。

平台服务层分为通用平台、数据平台。其中通用平台主要实现各类操作系统、中间件、工作流引擎等产品集成,为用户按需提供基础平台的调度服务。数据平台主要为信息共享及分析等业务需求,通过全面整合各类生产库资源,形成资源共享中心及分析型数据仓库建设,从而实现数据资源的按需调度。

软件服务层针对各类用户的业务特点,提供相应的云搜索、云比对、云分析等云服务。

高速公路数据资源中心系统架构如图1所示。

图1 数据资源中心系统架构

(二)资源需求设计

1、计算资源需求

(1)主机总体设计

主机计算资源由3种类型资源组成:数据库计算资源、应用计算资源、大数据服务器计算资源。

①数据库计算资源区

数据库计算资源区包括数据库、云计算与虚拟化管理平台、综合监控管理系统,时间同步系统。

数据库是数据中心的核心应用,对服务器计算性能、计算纵向扩展能力及响应延迟时间有较高要求,建议采用服务器双机热备的方式部署,实现关键业务的连续性与可用性。每个应用系统单独部署2台高端性能的四路物理服务器。

数据处理服务器是整个数据中心的IT基础设施资源核心管理系统,单独部署2台中端性能的四路物理服务器。

②应用计算资源区

应用计算资源区包括共享平台所部署的各类应用服务,分别为综合查询应用、邮件系统、即时通信系统、测试系统、备份软件系统、防病毒系统、数据交换系统、共享平台软件管理系统,主要负责承载应用系统的业务逻辑层计算。该类应用的特征是单个应用对计算资源、数据I/O读写、网络带宽的要求比较均衡,部分应用对计算能力有横向扩展的要求。采用应用计算资源池的方式部署应用,可有效提高服务器资源利用率。对于不同业务处理能力的业务系统,将分配不同规格的应用计算资源,以满足计算量要求。

③大数据服务器计算资源区

全文检索服务采用分布式大数据系统,大数据计算提供海量非结构化数据的分布式计算、处理和存储。结合平台应用,利用并行编程模型,可实现对非结构化数据的分布并行计算和业务处理,提高数据的处理效率。大数据计算节点采用分布式集群计算模式,计算节点集计算能力与存储能力于一身,集群采用2份副本的数据冗余保护机制,有效避免了单节点故障带来的数据丢失问题。

(2)资源设计

①数据库计算资源设计

数据库服务器的选择总体思想体现在CPU的缓存大、系统内存高、并发任务能力强、机器内部的I/O和总线带宽大,因此建议数据库服务器采用独立的物理机。

考虑后续业务对数据库服务器的需求,本期数据中心数据库服务器分别选用2台高性能数据库服务器,单台服务器配置4×CPU,256G内存,服务器之间通过数据库本身提供的集群软件实现数据库的高可用。

②应用计算资源设计

数据中心应用系统属于典型的联机事务处理型应用,系统对服务器的需求主要参考TPC-C值。服务器性能指标如下表所示。

服务器性能指标表

应用系统对TPMC的需求合计为1335269,按照每台服务器提供150000TPMC值计算,考虑系统一定冗余,本期数据中心所需服务器为四路服务器。

③大数据服务器资源设计

高速公路大数据中心整合多种数据源,提供分级的数据处理能力大数据基础设备资源池,实现海量结构化数据和非结构化数据的存储,能够支持原有业务应用的发展需求,并为新的基于大数据开发应用提供基础平台。

全文检索服务采用分布式大数据系统,实现对非结构化数据的全文检索、集群调度和内容管理功能,将复杂的计算分散到不同的普通性能、高I/O型性能的服务器上。文档检索服务包含两部分数据:一部分是原始数据,这部分数据用来读取,采用企业级机械硬盘可以满足要求;另外一部分是检索数据,对I/O时延要求高,采用高性能固态硬盘。

全文检索服务具有较高可靠性,因为其假设计算元素和存储会失败,因此维护多个工作数据副本,确保能够针对失败的节点重新分布处理。同时具有高效性,通过并行处理加快处理速度。

管理模块服务器:采用性能强、可靠性高、稳定性高的X86四路服务器,能提供强大的安全可靠的计算处理能力。管理模块需快速完成计算并提取索引、地址等数据,内存需求较大。

计算模块服务器:采用性能较强、可靠性高的X86四路存储服务器,性价比高,提供强大的存储空间、计算能力和安全可靠的运行环境,计算模块需要较大内存和较多大容量的硬盘。

2、存储资源需求

针对高速公路用户数据业务系统特点,存储资源池通过块存储系统为用户的虚拟机和物理服务器提供可按需扩展存储空间的块级别存储服务,用户虚拟机/物理服务器的操作系统以卷设备的方式访问块存储空间。

高速公路系统基础业务的典型业务架构为:Browser+Web服务器+应用服务器+DB数据库集群。其中Web服务器+应用服务器,可以采用虚拟化方式部署,存储可以采用传统的集中存储虚拟化技术,可以实现存储利旧。出于性能的考虑,建议DB数据库集群采用物理模式部署,使用传统的集中式存储存放数据表数据。

根据高速公路业务系统应用特色,构建存储云资源池的方式,建议采用集中存储方案存储传统应用数据。对于集中存储方案存在FC SAN、IP SAN和FCOE三种方案。

FC SAN方案:单独部署FC存储网络,选择FC SAN存储阵列支持。

IP SAN方案:采用iSCSI(在IP网络上运行SCSI协议)存储设备,存储网络和应用网络统一部署。

FCoE方案:采用支持以太网光纤信道FCoE(Fibre Channel over Ethernet)协议的存储设备,存储网络和应用网络统一部署。

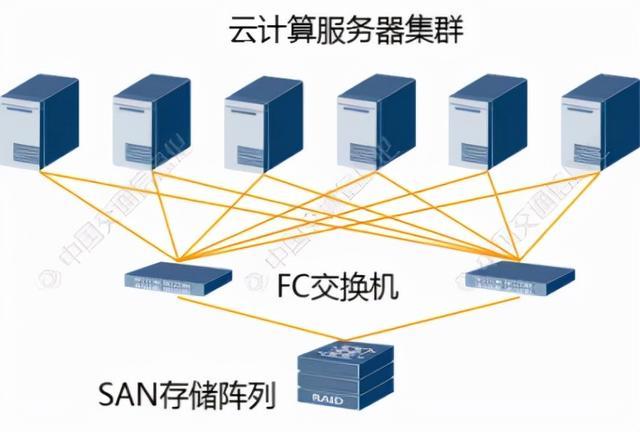

大数据中心存储系统采用FC-SAN双链路冗余结构的纯光纤存储系统。

FC-SAN双链路冗余纯光纤存储系统中含有多台应用及数据库服务器。其中数据库服务器做双机热备,其他业务应用服务器,通过服务器虚拟化软件组成虚拟化群,这些服务器通过本次所配8GB/S单口光纤通道卡和相应光纤跳线分别连接光纤通道交换机;再由光纤交换机接入磁盘阵列中。

同时为保证整体平台性能不遇瓶颈,核心存储采用高端自动分层架构,配置不少于10TB可用固态存储空间。同时为保证后期平台扩展与性能提升,要求采用国内市场销量前三的品牌,需具备完整的存储产品线,且同产品线产品可以高低搭配,产品线通用型号不少于5个。

由于本次为平台初建,整体方案采用单存储共享的方式进行平台搭建,为保证数据安全,本次配置一台备份一体化设备,保证核心数据库和应用的数据安全。为保证后期满足业务扩容和数据共享后的数据量要求,本次配置20TB备份容量,后期可扩展容量不小于300TB。

(三)网络拓扑设计

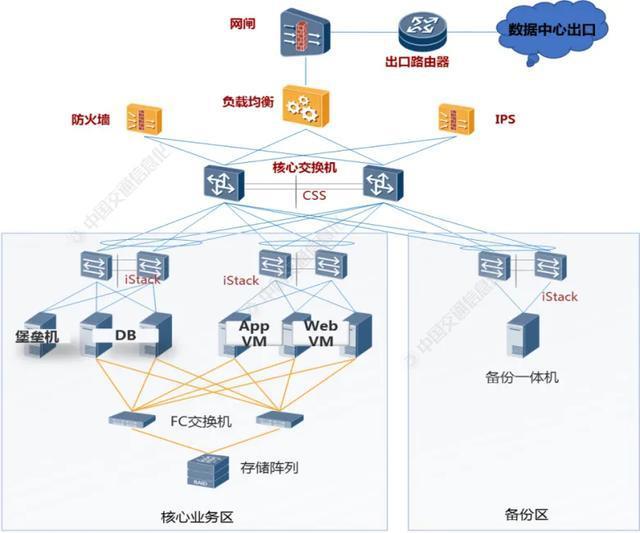

考虑到云数据中心的高安全性、高扩展能力和可管理性的业务需求,网络架构的总体规划遵循区域化、层次化和模块化的设计理念,使网络层次更加清楚、功能更加明确,提高承载的业务系统的可扩展性、安全性和可管理能力。

数据资源中心主要用于解决机构内、外部数据的归集、整理、共享、服务、分析、挖掘等方面存在的问题。系统架构设计采用两级架构,大数据中心直接服务各部门,提供基础架构资源,大数据中心与数据中心通过综合信息网互联,形成两级分布式数据中心架构。

考虑到数据中心内横向流量、纵向流量均比较大,因此在数据中心内组网主要分为两层:核心层、接入层。核心层由核心交换机、防火墙组成,接入层由接入交换机、服务器、存储等接入设备组成。为避免网络出现单点故障,数据中心内接入交换机建议全部采用堆叠组网,这样可以避免因交换机故障而导致的业务中断。

数据资源中心网络拓扑如图2所示。

图2 云数据中心网络拓扑

(四)云平台架构设计

1、逻辑架构

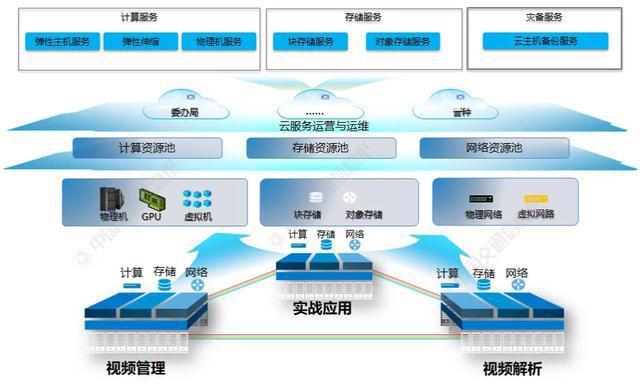

通过分布式云操作系统实现计算资源、存储资源、网络资源的池化,分别形成计算资源池、存储资源池、网络资源池,在资源池基础上构造虚拟数据中心VDC,支持对资源容量和配额管理,在划分VDC的基础上支持创建各种云服务,包括计算服务、存储服务、网络服务、灾备服务等,总体逻辑结构如图3所示。

图3 基础设施层逻辑架构

基础设施服务层主要提供如下服务。

(1)计算服务:包括弹性主机服务、物理机服务、弹性伸缩服务。

(2)存储服务:包括对象存储服务、块存储服务。

(3)灾备服务:包括云主机备份服务。

2、资源池设计

通过虚拟化等技术,实现计算、存储和网络资源的池化,构建自动化、弹性可扩展的CPU/GPU计算资源池,根据视频图像等不同种类数据的特点构建存储资源池;可支持软件定义网络,实现网络自动化部署和弹性扩展。最终,对上层服务提供虚拟机、物理机等计算服务、应用负载均衡服务、块存储/文件存储、大数据计算和大数据存储等基础设施服务能力。

(1)统一标准接口,实现IT资源开放共享

采用先进、开放、标准的云计算技术构建服务管理系统,有利于快速、统一完成业务部署。

(2)IT资源弹性分配、联动计算

服务管理系统支持根据各业务需求,以及突发事件应急保障需求,灵活调配视频图像计算、存储、分析资源,达到按需使用、弹性调度、灵活分配的目标。

(3)自动高效、节省运维人力

服务管理系统可以通过规范、统一、开放的资源服务接口,使业务系统可“菜单式”申请和调用各类计算资源和服务资源,可以在短时间内完成应用环境的构建和调整,应用开发可以做到“短、平、快”,快速适应业务需求变化。

3、计算资源池设计

云计算资源池可提供计算、网络、存储资源,为上层业务系统和支撑平台等提供统一的云资源服务,云平台需能平滑扩缩(扩容、减容)、平滑升级,保证扩容、减容、升级这些操作不影响已在云平台上运行的业务系统;云平台要具备上千台服务器的管理能力,至少满足未来3~5年业务增长对云资源扩展的需求。

(1)通用计算资源池

规划考虑采用通用的X86服务器架构,服务器虚拟化后形成统一的计算资源池。为上层业务系统和支撑平台等提供通用计算能力。

(2)裸金属资源池

对于涉及到一些不适合上虚拟化的应用,直接部署在物理机上,这部分物理机需要纳入云统一管理。

4、存储资源池设计

云计算服务通过2台FC交换机与SAN存储阵列互联,为保证链路可靠性,均采用双冗余架构设计。虚拟化SAN存储主要为云平台虚拟机提供云硬盘,用于安装操作系统以及存放数据。云存储中心网络拓扑如图4所示。

图4 云存储中心网络拓扑

三 结束语

本文针对高速公路大数据中心及沿线站所的网络环境、应用系统以及当前系统资源,分析了高速公路管理中心及站所的数据资源建设需求,结合国内现有数据中心建设规范和技术要求,对高速公路数据资源管理中心的功能建设进行了探讨,以期对高速公路数据中心、个站所数据资源建设起到借鉴作用,推进数据资源中心建设基本要求在高速公路管理中心、沿线站所的实际环境建设中落实、落地。